- SS: 有关基本算法或原理的文章,建议吃透

- S: 前沿顶刊文章,提出通用改进思路或算法创新

- A: 前沿顶刊文章,对某一问题提出针对性改进方法,但存在局限性或改进空间

- B: 非顶刊文章,可以参考

- C: 参考价值一般的文章

- O: 开源文章

论文记录

| 论文名 | [出处]模型名 | 任务 | 核心技术 | 突出优势与存在问题 | 比对模型 | 数据集 | 评价指标 |

|---|---|---|---|---|---|---|---|

| (AO)DIFFUSION-BASED GENERATIVE SPEECH SOURCE SEPARATION(2023) | [ICASSP 2023] DiffSep | 语音分离/增强 | 应该第一种基于扩散过程的语音源分离方法,主要是利用投影矩阵将混合语音投影为分离语音,使用了传统SDE,虽然效果不如Conv-Tasnet等方法,但其证明了扩散模型在语音分离领域的有效性,同时该模型可以在语音增强和语音分离两个任务上均可以使用 | 该方法没有利用到任何传统语音混合技术(如mel频谱),而且效果不如Conv-TasNet,同时在尝试复现时发现收敛结果和论文结果有出入,这代表其损失函数或模型存在设计缺陷,导致损失降低收敛结果缺不理想 | Conv-TasNet/CDiffuse/SGMSE+ | WSJ0-2mix/Libri2Mix VoiceBank-Demand(VCTK-Demand) | SI-SDR PESQ ESTOI OVRL |

| (A)SEPDIFF: SPEECH SEPARATION BASED ON DENOISING DIFFUSION MODEL | [ICASSP 2023] SepDiff | 单语音分离 | 对DDPM进行了一点点改造,主要体现在将语音的Mel频谱和原语音拼接作为模型输入,其次使用深层模型代替传统U-Net,每个上/下采用块使用类似多头注意力的结构 | 仅针对单语音分离而不是通用源分离,且训练和测试均使用同一数据集,模型鲁棒性存疑。除此以外还提到一个问题,生成模型使用在语音分离或语音增强由于产生的波形与GT总是不对齐,导致一般客观指标值会很低,解决这一问题一般方法是采用主观指标或者使用尺度不变客观指标(如SISDR) | Conv-TasNet/DPRNN/SepFormer | LibriMix | MOS POLQA WARP-Q |

| (B)Separate And Diffuse: Using a Pretrained Diffusion Model for Improving Source Separation | [arXiv-2023.6.24] | 语音分离 | 传统的确定性语音分离模型存在理论极限值,但生成模型的介入或许可以打破这一极限。使用一个预训练的分离模型(SepFormer)和一个预训练的扩散模型(DiffWave),再自行训练一个简单神经网络用于生成组合系数,在频域进行线性组合即可得到高质量的分离后语音。通过采用预训练的模型,大大减少了训练难度。同时文中尝试用GAN代替扩散模型,效果不太行。结果证明,该方法打破了确定性模型进行语音分离的理论上界,展示出了扩散模型的强大潜力。 | 算法突破的上限是在处理有限大小块的算法上下文中开发的,或许会存在新的方法打破该上限 | DiffSep/SepIt/SepFormer/Gated LSTM | WSJ0/LibriSpeech | SI-SDRi |

| (B)Target Speech Extraction with Conditional Diffusion Model | [InterSpeech2023] [arxiv-2023.8.17] Diff-TSE-MT | 语音提取 | 在一般的NCSN++分数网络前添加了和普通TSE模型类似的预处理残差模块,在T=t时使用备用损失。明确指出生成模型在语音任务中不仅可以增强预处理后的语音,还可以弥补预处理后语音中可能遗漏的信息。 | 扩散模型的生成样本存在随机性,导致分离结果时好时坏,文中的解决方法是多次使用不同种子进行采样,再对多个生成样本进行集成。但尽管如此虽然在增强任务中表现出色,但在TSE任务中表现仍不如主流模型 | SpeakerBeam | Libri2Mix-2spk | PESQ ESTOI SI-SDR |

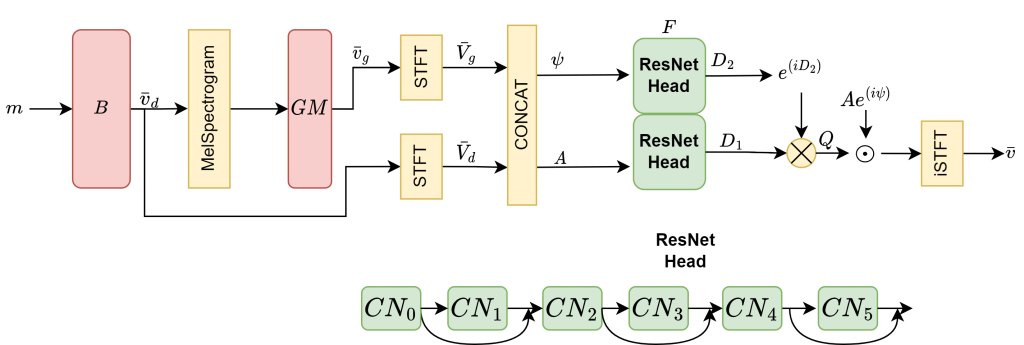

| (AO)DPM-TSE: A DIFFUSION PROBABILISTIC MODEL FOR TARGET SOUND EXTRACTION | [ICASSP 2024] DPM-TSE | 语音提取 | 首次在TSE任务中使用传统概率扩散模型DPM,为了解决扩散模型不善于提取语音的沉默片段,其引入了预测速度v,并在扩散模型后接入了用于波形重建的神经声码器(文中用的是HiFi-GAN) | 使用原始噪声调度的DPM-TSE在非目标声音区域产生了额外的噪声,如果接入的声码器过大也会造成性能下降(可能是过拟合) | WaveFormer/Tim-TSENet | Freesound Dataset Kaggle 2018 corpus (FSD) | ViSQQL-T CDPAM-T |

| (AO)Diff-SV: A Unified Hierarchical Framework for Noise-Robust Speaker Verification | [ICASSP 2024] Diff-SV | 说话人验证 | 融合多项技术的说话人验证系统,主要包括基于线性块和Transformer块的增强器(从有噪声的梅尔谱图中提取增强特征),基于分数去噪模型的去噪器,和基于ResNet的提取器.总损失为三者损失函数之和,三者一起训练 | 是目前说话人验证效果最佳的模型,但其创新点主要体现在音频预处理方面,本质上是三个模型的串联使其相对臃肿,且参数不用复现就能看出来相当巨大 | NDML/Ex-UNet | VoxCeleb1+MUSAN(加噪)/VOiCES(验证集) | EER 最小成本检测函数DCF |

| (SO)Speech Enhancement with Score-Based Generative Models in the Complex STFT Domain | [InterSpeech2022] SGMSE | 语音增强 | 明确指出DDPM模型在语音增强任务中的歧义性缺陷,首次使用SGM进行语音增强,并在STFT域处理数据,使用幅度变换解决STFT的重尾问题 | 没有使用PESQ指标只使用尺度不变指标,原因是使用的数据集不符PESQ评判标准,既然如此为什么不用WSJ0训练?猜测可能是客观指标效果不好【此问题已被SGMSE+解决】 | DiffuSE/CDiffuSE | VoiceBank-Demand | SI-SDR SI-SAR SI-SIR |

| (SO)Speech Enhancement and Dereverberation With Diffusion-Based Generative Models | [TASLP-2023.7.13] SGMSE+ | 语音增强/去混响 | 在SGMSE的基础上,改用更复杂的U-Net,且通过比较ODE和带纠正步DC采样器,判断出带纠正步的DC采样器效果很好。使用纠正步采样器可能是解决沉默区间生成问题 | StoRM中就指出了这种纠正器会增加采样计算量;一些超参数需要根据训练集的不同进行修改较为麻烦。 尝试复现时发现,所使用的U-Net过于臃肿,参数量相比SGMSE从3M飙升到65.6M,而且由于SDE的原因采样步数高达1000,导致训练异常困难 | STCN/RVAE/CDiffuse/SGMSE/MetricGAN+/Conv-TasNet | WSJ0-Chime3/VB-Demand | POLQA PESQ ESTOI SI-SDR SI-SAR SI-SIR |

| (DO)EARS: An Anechoic Fullband Speech Dataset Benchmarked for Speech Enhancement and Dereverberation | [arxiv-2024-6.11] EARS | 数据集 | SGMSE作者团队制作的纯净语音数据集。一般数据集只包含平调中性语音风格,此数据集则包含窃窃私语/大声/喊叫等风格和情绪,除此以外还制作了EARS-WHAM变体数据集用于语音增强和去混响任务,SGMSE在此数据集表现极佳。详见 https://sp-uhh.github.io/ears_dataset/ | 部分参数: 100hours, 107speakers, 48kHz 在SGMSE+模型上训练时使用4长RTX A6000都只能batch_size=4,似乎规模很大 | Conv-TasNet/CDiffuSE/Demucs/SGMSE+ | – | POLQA SI-SDR PESQ ESTOI &SIGMOS &DNSMOS |

(AO)DIFFUSION-BASED GENERATIVE SPEECH SOURCE SEPARATION(2023)

(DiffSep)应该第一种基于扩散过程的语音源分离方法,主要是利用投影矩阵将混合语音投影为分离语音,使用了传统SDE,虽然效果不如Conv-Tasnet等方法,但其证明了扩散模型在语音分离领域的有效性,同时该模型可以在语音增强和语音分离两个任务上均可以使用

(A)SEPDIFF: SPEECH SEPARATION BASED ON DENOISING DIFFUSION MODEL

(B)Target Speech Extraction with Conditional Diffusion Model

(B)Separate And Diffuse: Using a Pretrained Diffusion Model for Improving Source Separation(2023)

传统的确定性语音分离模型存在理论极限值,但生成模型的介入或许可以打破这一极限。使用一个预训练的分离模型(SepFormer)和一个预训练的扩散模型(DiffWave),再自行训练一个简单神经网络用于生成组合系数,在频域进行线性组合即可得到高质量的分离后语音。通过采用预训练的模型,大大减少了训练难度。同时文中尝试用GAN代替扩散模型,效果不太行。结果证明,该方法打破了确定性模型进行语音分离的理论上界,展示出了扩散模型的强大潜力。

http://wish-club.ru/forums/index.php?autocom=gallery&req=si&img=5228

https://mazda-demio.ru/forums/index.php?autocom=gallery&req=si&img=6399

https://vitz.ru/forums/index.php?autocom=gallery&req=si&img=4954

https://honda-fit.ru/forums/index.php?autocom=gallery&req=si&img=7253

Good https://is.gd/tpjNyL

https://mazda-demio.ru/forums/index.php?autocom=gallery&req=si&img=6497

https://myteana.ru/forums/index.php?autocom=gallery&req=si&img=6886

https://mazda-demio.ru/forums/index.php?autocom=gallery&req=si&img=6469

https://hrv-club.ru/forums/index.php?autocom=gallery&req=si&img=6985

http://terios2.ru/forums/index.php?autocom=gallery&req=si&img=4656

https://vitz.ru/forums/index.php?autocom=gallery&req=si&img=4909

http://wish-club.ru/forums/index.php?autocom=gallery&req=si&img=5258

Торегали Тореали – Арман кыз скачать песню в mp3 и слушать онлайн https://shorturl.fm/W8OCp

Алексей Воробьёв feat. Зураб Матуа & Андрей Аверин & Дмитрий Сорокин – Сумасшедшая скачать и слушать онлайн https://shorturl.fm/04nuO

Потап и Настя – Свадьба скачать mp3 и слушать онлайн https://shorturl.fm/zTKho

Звонкий – Shine скачать mp3 и слушать онлайн https://shorturl.fm/MCnar

https://honda-fit.ru/forums/index.php?autocom=gallery&req=si&img=7198

http://terios2.ru/forums/index.php?autocom=gallery&req=si&img=4750

https://mazda-demio.ru/forums/index.php?autocom=gallery&req=si&img=6537

https://forum.stde.ru/index.php?/gallery/image/829-16/

http://terios2.ru/forums/index.php?autocom=gallery&req=si&img=4557

https://vitz.ru/forums/index.php?autocom=gallery&req=si&img=4900